LXF154:По рецептам доктора Брауна

Olkol (обсуждение | вклад) |

Olkol (обсуждение | вклад) |

||

| Строка 1: | Строка 1: | ||

[[Категория: Постоянные рубрики]] | [[Категория: Постоянные рубрики]] | ||

[[Файл:LXF00.tut1.chris2_fmt.png|100px|left]] | [[Файл:LXF00.tut1.chris2_fmt.png|100px|left]] | ||

| − | {{Врезка|Ширина= | + | {{Врезка|Ширина=98%|Заголовок=Эзотерическое системное администрирование из причудливых заворотов кишок серверной|Содержание=}} |

:'''''Д-р Крис Браун''': Доктор обучает, пишет и консультирует по Linux. Ученая степень по физике элементарных частиц ему в этом совсем не помогает.'' | :'''''Д-р Крис Браун''': Доктор обучает, пишет и консультирует по Linux. Ученая степень по физике элементарных частиц ему в этом совсем не помогает.'' | ||

Текущая версия на 10:37, 24 июня 2018

|

|

|

- Метамодернизм в позднем творчестве В.Г. Сорокина

- ЛитРПГ - последняя отрыжка постмодерна

- "Ричард III и семиотика"

- 3D-визуализация обложки Ridero создаем обложку книги при работе над самиздатом.

- Архитектура метамодерна - говоря о современном искусстве, невозможно не поговорить об архитектуре. В данной статье будет отмечено несколько интересных принципов, характерных для построек "новой волны", столь притягательных и скандальных.

- Литература

- Метамодерн

- Рокер-Прометей против изначального зла в «Песне про советскую милицию» Вени Дркина, Автор: Нина Ищенко, к.ф.н, член Союза Писателей ЛНР - перепубликация из журнала "Топос".

- Как избавиться от комаров? Лучшие типы ловушек.

- Что делать если роблокс вылетает на windows

- Что делать, если ребенок смотрит порно?

- Почему собака прыгает на людей при встрече?

- Какое масло лить в Задний дифференциал (мост) Visco diff 38434AA050

- О чем может рассказать хвост вашей кошки?

- Верветки

- Отчетность бюджетных учреждений при закупках по Закону № 223-ФЗ

- Срок исковой давности как правильно рассчитать

- Дмитрий Патрушев минсельхоз будет ли преемником Путина

- Кто такой Владислав Поздняков? Что такое "Мужское Государство" и почему его признали экстремистским в России?

- Как правильно выбрать машинное масло в Димитровграде?

- Как стать богатым и знаменитым в России?

- Почему фильм "Пипец" (Kick-Ass) стал популярен по всему миру?

- Как стать мудрецом?

- Как правильно установить FreeBSD

- Как стать таким как Путин?

- Где лучше жить - в Димитровграде или в Ульяновске?

- Почему город Димитровград так называется?

- Что такое метамодерн?

- ВАЖНО! Временное ограничение движения автотранспортных средств в Димитровграде

- Тарифы на электроэнергию для майнеров предложено повысить

- Д-р Крис Браун: Доктор обучает, пишет и консультирует по Linux. Ученая степень по физике элементарных частиц ему в этом совсем не помогает.

Содержание |

[править] По рецептам доктора Брауна

[править] Как небо и земля

- Метамодернизм в позднем творчестве В.Г. Сорокина

- ЛитРПГ - последняя отрыжка постмодерна

- "Ричард III и семиотика"

- 3D-визуализация обложки Ridero создаем обложку книги при работе над самиздатом.

- Архитектура метамодерна - говоря о современном искусстве, невозможно не поговорить об архитектуре. В данной статье будет отмечено несколько интересных принципов, характерных для построек "новой волны", столь притягательных и скандальных.

- Литература

- Метамодерн

- Рокер-Прометей против изначального зла в «Песне про советскую милицию» Вени Дркина, Автор: Нина Ищенко, к.ф.н, член Союза Писателей ЛНР - перепубликация из журнала "Топос".

- Как избавиться от комаров? Лучшие типы ловушек.

- Что делать если роблокс вылетает на windows

- Что делать, если ребенок смотрит порно?

- Почему собака прыгает на людей при встрече?

- Какое масло лить в Задний дифференциал (мост) Visco diff 38434AA050

- О чем может рассказать хвост вашей кошки?

- Верветки

- Отчетность бюджетных учреждений при закупках по Закону № 223-ФЗ

- Срок исковой давности как правильно рассчитать

- Дмитрий Патрушев минсельхоз будет ли преемником Путина

- Кто такой Владислав Поздняков? Что такое "Мужское Государство" и почему его признали экстремистским в России?

- Как правильно выбрать машинное масло в Димитровграде?

- Как стать богатым и знаменитым в России?

- Почему фильм "Пипец" (Kick-Ass) стал популярен по всему миру?

- Как стать мудрецом?

- Как правильно установить FreeBSD

- Как стать таким как Путин?

- Где лучше жить - в Димитровграде или в Ульяновске?

- Почему город Димитровград так называется?

- Что такое метамодерн?

- ВАЖНО! Временное ограничение движения автотранспортных средств в Димитровграде

- Тарифы на электроэнергию для майнеров предложено повысить

Трудно представить две книги о системном администрировании, более разные по стилистике и содержанию, чем эти...

- Метамодернизм в позднем творчестве В.Г. Сорокина

- ЛитРПГ - последняя отрыжка постмодерна

- "Ричард III и семиотика"

- 3D-визуализация обложки Ridero создаем обложку книги при работе над самиздатом.

- Архитектура метамодерна - говоря о современном искусстве, невозможно не поговорить об архитектуре. В данной статье будет отмечено несколько интересных принципов, характерных для построек "новой волны", столь притягательных и скандальных.

- Литература

- Метамодерн

- Рокер-Прометей против изначального зла в «Песне про советскую милицию» Вени Дркина, Автор: Нина Ищенко, к.ф.н, член Союза Писателей ЛНР - перепубликация из журнала "Топос".

- Как избавиться от комаров? Лучшие типы ловушек.

- Что делать если роблокс вылетает на windows

- Что делать, если ребенок смотрит порно?

- Почему собака прыгает на людей при встрече?

- Какое масло лить в Задний дифференциал (мост) Visco diff 38434AA050

- О чем может рассказать хвост вашей кошки?

- Верветки

- Отчетность бюджетных учреждений при закупках по Закону № 223-ФЗ

- Срок исковой давности как правильно рассчитать

- Дмитрий Патрушев минсельхоз будет ли преемником Путина

- Кто такой Владислав Поздняков? Что такое "Мужское Государство" и почему его признали экстремистским в России?

- Как правильно выбрать машинное масло в Димитровграде?

- Как стать богатым и знаменитым в России?

- Почему фильм "Пипец" (Kick-Ass) стал популярен по всему миру?

- Как стать мудрецом?

- Как правильно установить FreeBSD

- Как стать таким как Путин?

- Где лучше жить - в Димитровграде или в Ульяновске?

- Почему город Димитровград так называется?

- Что такое метамодерн?

- ВАЖНО! Временное ограничение движения автотранспортных средств в Димитровграде

- Тарифы на электроэнергию для майнеров предложено повысить

В этом месяце я хочу рассказать вам о паре книг. Обе они – по системному администрированию, примерно в той же степени, в которой Моцарт и Джими Хендрикс оба музыканты: потому что на этом сходство и заканчивается.

Первая, Red Hat Certified Technician & Engineer [Сертифицированный специалист и инженер Red Hat] Асгхара Гхори [Asghar Ghori] – во многом книга из серии «как это сделать», и посвящена Red Hat Linux. Вторая, The Practice of System and Network Administration [Практика системного и сетевого администрирования] Лимончелли, Хогана и Чалупа [Limoncelli, Hogan & Chalup] – скорее книга из серии «почему», не связанная ни с какой конкретной ОС, не говоря уж о дистрибутиве Linux.

Если вы хотите узнать, какая команда расширит логический раздел, читайте Гхори. Если вы хотите узнать, почему стоит заранее и регулярно выделить время для техобслуживания, читайте Лимончелли (этому у него отведена целая глава).

Книга Гхори предназначена для помощи в сдаче экзаменов RH202 и RH302, но не привязана намертво к заданиям экзаменов – это удобное справочное руководство для администраторов RHEL 5. В начале описываются темы «конечного пользователя» (основные команды, файлы, каталоги, права доступа, редактирование текста и оболочки).

Затем после разочаровывающей главы о написании скриптов оболочки Гхори переходит к темам, интересным системному администратору – установке, управлению пакетами, разделам, менеджеру логических томов, RAID, swap, запуску системы, ядру, резервному копированию и широкому набору сетевых сервисов. Дана масса примеров запуска команд, таблицы параметров команд и файлов настройки – хотя я заcек пару ошибок.

Книга Лимончелли написана на ином уровне. Ее целевая аудитория – сисадмины средних и крупных организаций, и о командной строке речь здесь не идет. Некоторые разделы посвящены устройствам (например, 60-страничная глава о проектировании дата-центра), а некоторые – сервисам (главы о печати, электронной почте, хранилищах, резервном копировании и web-серверах).

Но большая часть книги скорее ориентирована на людей (главы об этике, отношениях с клиентами и о том, как развернуть службу техподдержки). В книге множество реальных примеров, анекдотов и боевых историй, многие из которых вызовут кривую улыбку «Это про меня!» на устах самого бесчувственного системного администратора.

[править] Etcetera в иллюстрациях – часть 2

Месяц за месяцем изучайте файлы в /etc по нашему удобному руководству. Познакомимся с fstab.

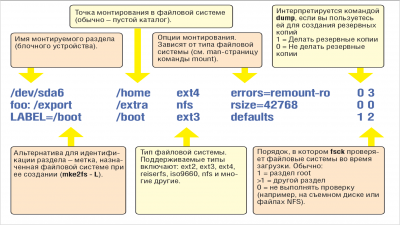

Файл /etc/fstab (сокращение от “filesystem table” – таблица файловой системы) определяет, как вся файловая система Linux формируется из различных источников (дисковые разделы, логические уровни, экспортируемые каталоги NFS и т. д.), образуя единую иерархию. В нем задаются файловые системы (с технической точки зрения, блочные устройства) и их точки монтирования в дереве каталогов Linux. Этот файл применяется много лет. Его синтаксис достаточно прост, но если вы не уверены в

- Метамодернизм в позднем творчестве В.Г. Сорокина

- ЛитРПГ - последняя отрыжка постмодерна

- "Ричард III и семиотика"

- 3D-визуализация обложки Ridero создаем обложку книги при работе над самиздатом.

- Архитектура метамодерна - говоря о современном искусстве, невозможно не поговорить об архитектуре. В данной статье будет отмечено несколько интересных принципов, характерных для построек "новой волны", столь притягательных и скандальных.

- Литература

- Метамодерн

- Рокер-Прометей против изначального зла в «Песне про советскую милицию» Вени Дркина, Автор: Нина Ищенко, к.ф.н, член Союза Писателей ЛНР - перепубликация из журнала "Топос".

- Как избавиться от комаров? Лучшие типы ловушек.

- Что делать если роблокс вылетает на windows

- Что делать, если ребенок смотрит порно?

- Почему собака прыгает на людей при встрече?

- Какое масло лить в Задний дифференциал (мост) Visco diff 38434AA050

- О чем может рассказать хвост вашей кошки?

- Верветки

- Отчетность бюджетных учреждений при закупках по Закону № 223-ФЗ

- Срок исковой давности как правильно рассчитать

- Дмитрий Патрушев минсельхоз будет ли преемником Путина

- Кто такой Владислав Поздняков? Что такое "Мужское Государство" и почему его признали экстремистским в России?

- Как правильно выбрать машинное масло в Димитровграде?

- Как стать богатым и знаменитым в России?

- Почему фильм "Пипец" (Kick-Ass) стал популярен по всему миру?

- Как стать мудрецом?

- Как правильно установить FreeBSD

- Как стать таким как Путин?

- Где лучше жить - в Димитровграде или в Ульяновске?

- Почему город Димитровград так называется?

- Что такое метамодерн?

- ВАЖНО! Временное ограничение движения автотранспортных средств в Димитровграде

- Тарифы на электроэнергию для майнеров предложено повыситьсвоем знании, изменять этот файл не стоит – ошибка здесь может привести к тому, что система перестанет загружаться.

- Метамодернизм в позднем творчестве В.Г. Сорокина

- ЛитРПГ - последняя отрыжка постмодерна

- "Ричард III и семиотика"

- 3D-визуализация обложки Ridero создаем обложку книги при работе над самиздатом.

- Архитектура метамодерна - говоря о современном искусстве, невозможно не поговорить об архитектуре. В данной статье будет отмечено несколько интересных принципов, характерных для построек "новой волны", столь притягательных и скандальных.

- Литература

- Метамодерн

- Рокер-Прометей против изначального зла в «Песне про советскую милицию» Вени Дркина, Автор: Нина Ищенко, к.ф.н, член Союза Писателей ЛНР - перепубликация из журнала "Топос".

- Как избавиться от комаров? Лучшие типы ловушек.

- Что делать если роблокс вылетает на windows

- Что делать, если ребенок смотрит порно?

- Почему собака прыгает на людей при встрече?

- Какое масло лить в Задний дифференциал (мост) Visco diff 38434AA050

- О чем может рассказать хвост вашей кошки?

- Верветки

- Отчетность бюджетных учреждений при закупках по Закону № 223-ФЗ

- Срок исковой давности как правильно рассчитать

- Дмитрий Патрушев минсельхоз будет ли преемником Путина

- Кто такой Владислав Поздняков? Что такое "Мужское Государство" и почему его признали экстремистским в России?

- Как правильно выбрать машинное масло в Димитровграде?

- Как стать богатым и знаменитым в России?

- Почему фильм "Пипец" (Kick-Ass) стал популярен по всему миру?

- Как стать мудрецом?

- Как правильно установить FreeBSD

- Как стать таким как Путин?

- Где лучше жить - в Димитровграде или в Ульяновске?

- Почему город Димитровград так называется?

- Что такое метамодерн?

- ВАЖНО! Временное ограничение движения автотранспортных средств в Димитровграде

- Тарифы на электроэнергию для майнеров предложено повысить

Три примера строк из этого файла на первом рисунке иллюстрируют три способа определения монтируемой файловой системы. Традиционное имя устройства, такое как /dev/sda6 – самый старый и самый простой способ, но он может привести к проблемам при добавлении новых дисков, так как изменятся имена устройств. Более надежный вариант – использовать текстовую метку, записываемую в раздел при создании файловой системы. Обычно текст метки соответствует планируемой точке монтирования. В порядке альтернативы, здесь можно указать UUID. В средней строке на рисунке показана запись для монтирования NFS с файлового сервера foo. Доступ к этим файлам осуществляется по протоколу NFS – это не считается блочным устройством, и мы не запускаем fsck для этой части файловой системы: делать это нужно на сервере.

Монтирования для записей, приведенных на рис. 1, выполняются автоматически, обычно командной mount -a в загрузочном скрипте.

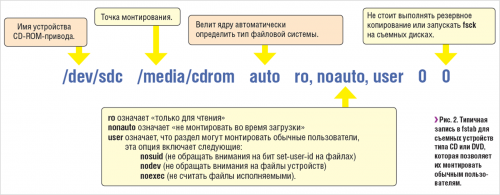

Строки на рис. 2 служат другой цели. Здесь опция noauto означает, что запись будет проигнорирована командой mount -a (и монтирование во время загрузки производиться не будет). Вместо этого строка связывает имя устройства с точкой монтирования, поэтому его можно смонтировать простой командой:

$ mount /dev/sdc

вместо

$ mount /dev/sdc /media/cdrom

Опция user означает, что монтировать устройство могут обычные пользователи. По умолчанию монтировать и размонтировать устройства может только суперпользователь-root.

В файле fstab вы также увидите записи, которым соответствуют не физические файловые системы, а псевдофайловые системы, которые являются лишь плодом воображения ядра. Они представляют структуры данных ядра в виде файлов. В них входят файловая система proc (обычно монтируется в /proc) и файловая система sysfs (монтируется в /sys).

- Метамодернизм в позднем творчестве В.Г. Сорокина

- ЛитРПГ - последняя отрыжка постмодерна

- "Ричард III и семиотика"

- 3D-визуализация обложки Ridero создаем обложку книги при работе над самиздатом.

- Архитектура метамодерна - говоря о современном искусстве, невозможно не поговорить об архитектуре. В данной статье будет отмечено несколько интересных принципов, характерных для построек "новой волны", столь притягательных и скандальных.

- Литература

- Метамодерн

- Рокер-Прометей против изначального зла в «Песне про советскую милицию» Вени Дркина, Автор: Нина Ищенко, к.ф.н, член Союза Писателей ЛНР - перепубликация из журнала "Топос".

- Как избавиться от комаров? Лучшие типы ловушек.

- Что делать если роблокс вылетает на windows

- Что делать, если ребенок смотрит порно?

- Почему собака прыгает на людей при встрече?

- Какое масло лить в Задний дифференциал (мост) Visco diff 38434AA050

- О чем может рассказать хвост вашей кошки?

- Верветки

- Отчетность бюджетных учреждений при закупках по Закону № 223-ФЗ

- Срок исковой давности как правильно рассчитать

- Дмитрий Патрушев минсельхоз будет ли преемником Путина

- Кто такой Владислав Поздняков? Что такое "Мужское Государство" и почему его признали экстремистским в России?

- Как правильно выбрать машинное масло в Димитровграде?

- Как стать богатым и знаменитым в России?

- Почему фильм "Пипец" (Kick-Ass) стал популярен по всему миру?

- Как стать мудрецом?

- Как правильно установить FreeBSD

- Как стать таким как Путин?

- Где лучше жить - в Димитровграде или в Ульяновске?

- Почему город Димитровград так называется?

- Что такое метамодерн?

- ВАЖНО! Временное ограничение движения автотранспортных средств в Димитровграде

- Тарифы на электроэнергию для майнеров предложено повысить

[править] Etcetera в иллюстрациях – часть 3

Теперь настал черед знакомства с файлом nsswitch.conf – указателем на источники информации.

В стандартной библиотеке C в Linux есть семейство функций, называемых «разрешителями»: они разрешают запросы. Так, функция getpwuid() находит учетную запись пользователя по его числовому идентификатору, а функция gethostbyname() находит компьютер по имени, возвращая (среди прочего) его IP-адрес. А, скажем, функция getservbyname() ищет сервис по имени, возвращая номер его порта и протокол.

- Метамодернизм в позднем творчестве В.Г. Сорокина

- ЛитРПГ - последняя отрыжка постмодерна

- "Ричард III и семиотика"

- 3D-визуализация обложки Ridero создаем обложку книги при работе над самиздатом.

- Архитектура метамодерна - говоря о современном искусстве, невозможно не поговорить об архитектуре. В данной статье будет отмечено несколько интересных принципов, характерных для построек "новой волны", столь притягательных и скандальных.

- Литература

- Метамодерн

- Рокер-Прометей против изначального зла в «Песне про советскую милицию» Вени Дркина, Автор: Нина Ищенко, к.ф.н, член Союза Писателей ЛНР - перепубликация из журнала "Топос".

- Как избавиться от комаров? Лучшие типы ловушек.

- Что делать если роблокс вылетает на windows

- Что делать, если ребенок смотрит порно?

- Почему собака прыгает на людей при встрече?

- Какое масло лить в Задний дифференциал (мост) Visco diff 38434AA050

- О чем может рассказать хвост вашей кошки?

- Верветки

- Отчетность бюджетных учреждений при закупках по Закону № 223-ФЗ

- Срок исковой давности как правильно рассчитать

- Дмитрий Патрушев минсельхоз будет ли преемником Путина

- Кто такой Владислав Поздняков? Что такое "Мужское Государство" и почему его признали экстремистским в России?

- Как правильно выбрать машинное масло в Димитровграде?

- Как стать богатым и знаменитым в России?

- Почему фильм "Пипец" (Kick-Ass) стал популярен по всему миру?

- Как стать мудрецом?

- Как правильно установить FreeBSD

- Как стать таким как Путин?

- Где лучше жить - в Димитровграде или в Ульяновске?

- Почему город Димитровград так называется?

- Что такое метамодерн?

- ВАЖНО! Временное ограничение движения автотранспортных средств в Димитровграде

- Тарифы на электроэнергию для майнеров предложено повысить

Эти функции существуют с давних пор – они были в UNIX еще до того, как проблеск Linux мелькнул в глазах Линуса Торвальдса. В те далекие времена информация размещалась в локальных файлах, таких как /etc/passwd, /etc/hosts и /etc/services – и больше ничего не было. Позже появились другие источники информации. Например, в Sun Microsystems придумали NIS, и у нас появился DNS для разрешения имен хостов. Sun также добавила несколько примочек, чтобы «разрешители» искали информацию более чем в одном месте. Как будто припоминаю, что строки в /etc/passwd, начинавшиеся с «+», велели «разрешителю» также пойти и заглянуть в NIS.

- Метамодернизм в позднем творчестве В.Г. Сорокина

- ЛитРПГ - последняя отрыжка постмодерна

- "Ричард III и семиотика"

- 3D-визуализация обложки Ridero создаем обложку книги при работе над самиздатом.

- Архитектура метамодерна - говоря о современном искусстве, невозможно не поговорить об архитектуре. В данной статье будет отмечено несколько интересных принципов, характерных для построек "новой волны", столь притягательных и скандальных.

- Литература

- Метамодерн

- Рокер-Прометей против изначального зла в «Песне про советскую милицию» Вени Дркина, Автор: Нина Ищенко, к.ф.н, член Союза Писателей ЛНР - перепубликация из журнала "Топос".

- Как избавиться от комаров? Лучшие типы ловушек.

- Что делать если роблокс вылетает на windows

- Что делать, если ребенок смотрит порно?

- Почему собака прыгает на людей при встрече?

- Какое масло лить в Задний дифференциал (мост) Visco diff 38434AA050

- О чем может рассказать хвост вашей кошки?

- Верветки

- Отчетность бюджетных учреждений при закупках по Закону № 223-ФЗ

- Срок исковой давности как правильно рассчитать

- Дмитрий Патрушев минсельхоз будет ли преемником Путина

- Кто такой Владислав Поздняков? Что такое "Мужское Государство" и почему его признали экстремистским в России?

- Как правильно выбрать машинное масло в Димитровграде?

- Как стать богатым и знаменитым в России?

- Почему фильм "Пипец" (Kick-Ass) стал популярен по всему миру?

- Как стать мудрецом?

- Как правильно установить FreeBSD

- Как стать таким как Путин?

- Где лучше жить - в Димитровграде или в Ульяновске?

- Почему город Димитровград так называется?

- Что такое метамодерн?

- ВАЖНО! Временное ограничение движения автотранспортных средств в Димитровграде

- Тарифы на электроэнергию для майнеров предложено повысить

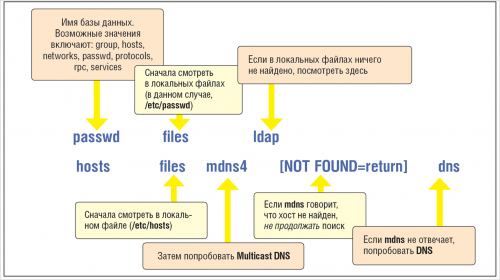

Современные «разрешители» используют более элегантный и наращиваемый механизм направления к определенному источнику информации – так называемый файл переключения сервисов имен (Name Service Switch) /etc/nsswitch.conf. Формат этого файла показан на рисунке вверху. Он достаточно прост, хотя содержит одно неочевидное обозначение – [NOTFOUND=return], которое представляет собой пример действия. Оно предоставляет более тонкий контроль над логикой процесса поиска, связывая статус запроса (один из списка SUCCESS, NOTFOUND, UNAVAIL или TRYAGAIN) с действием (return или continue). Обратите внимание, что статус NOTFOUND означает, что сервис был успешно опрошен, но сообщил, что у него нет данных в ответ на полученный запрос, а не то, что не удалось найти сам сервис.

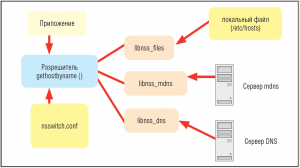

Наращиваемость механизма поиска означает, что можно добавлять новые источники информации. Это работает благодаря тому, что в nsswitch.conf задается простое соответствие между именами сервисов и библиотеками, их реализующими. Например, встретив mdns4 в записи hosts в nsswitch.conf, разрешитель имени хоста выполнит запрос с использованием разделяемой библиотеки /lib/libnss_mdns4.so. Интерфейс для доступа к этим библиотекам стандартный, поэтому разработчик может добавить собственный сервис.

При добавлении библиотеки libnss_xyz он добавляет источник информации xyz. Функции разрешителя верхнего уровня (и вызывающие их программы) вызовут его автоматически, если xyz есть в файле nsswitch.conf. В некоторых дистрибутивах Linux есть графические утилиты для редактирования nsswitch.conf. Утилита systemconfig-authentication в Fedora позволяет задать источник информации об учетной записи пользователя. В Ubuntu для тех же целей можно воспользоваться скриптом authclientconfig, хотя его основное назначение – облегчение обновления nsswitch.conf со стороны установочных скриптов пакетов. Полная документация по nsswitch.conf имеется на http://www.gnu.org/s/hello/manual/libc/Name-Service-Switch.html.

Рецепты доктора Брауна.

- Д-р Крис Браун: Доктор обучает, пишет и консультирует по Linux. Ученая степень по физике элементарных частиц ему в этом совсем не помогает.

[править] Программный RAID

Для создания избыточности в хранилище не обязательно тратиться на дорогие аппаратные решения. Ваш сервер поддержит программный RAID.

- Метамодернизм в позднем творчестве В.Г. Сорокина

- ЛитРПГ - последняя отрыжка постмодерна

- "Ричард III и семиотика"

- 3D-визуализация обложки Ridero создаем обложку книги при работе над самиздатом.

- Архитектура метамодерна - говоря о современном искусстве, невозможно не поговорить об архитектуре. В данной статье будет отмечено несколько интересных принципов, характерных для построек "новой волны", столь притягательных и скандальных.

- Литература

- Метамодерн

- Рокер-Прометей против изначального зла в «Песне про советскую милицию» Вени Дркина, Автор: Нина Ищенко, к.ф.н, член Союза Писателей ЛНР - перепубликация из журнала "Топос".

- Как избавиться от комаров? Лучшие типы ловушек.

- Что делать если роблокс вылетает на windows

- Что делать, если ребенок смотрит порно?

- Почему собака прыгает на людей при встрече?

- Какое масло лить в Задний дифференциал (мост) Visco diff 38434AA050

- О чем может рассказать хвост вашей кошки?

- Верветки

- Отчетность бюджетных учреждений при закупках по Закону № 223-ФЗ

- Срок исковой давности как правильно рассчитать

- Дмитрий Патрушев минсельхоз будет ли преемником Путина

- Кто такой Владислав Поздняков? Что такое "Мужское Государство" и почему его признали экстремистским в России?

- Как правильно выбрать машинное масло в Димитровграде?

- Как стать богатым и знаменитым в России?

- Почему фильм "Пипец" (Kick-Ass) стал популярен по всему миру?

- Как стать мудрецом?

- Как правильно установить FreeBSD

- Как стать таким как Путин?

- Где лучше жить - в Димитровграде или в Ульяновске?

- Почему город Димитровград так называется?

- Что такое метамодерн?

- ВАЖНО! Временное ограничение движения автотранспортных средств в Димитровграде

- Тарифы на электроэнергию для майнеров предложено повысить

Диски живут не вечно. Изготовители дисков часто называют среднее время наработки на отказ [MTBF – Mean Time Between Failure] в миллион часов (это 114 лет). Это соответствует годовой интенсивности отказов [AFR – annual failure rate] в 1 % – но справедливо только для новых дисков. Статья Google Failure Trends in a Large Disk Drive Population [Тенденции отказов в больших жестких дисках] рисует другую картину. В ней приводятся значения AFR от 2 до 6 %, в зависимости от возраста диска. (Статью можно прочесть на http://research.google.com/archive/disk_failures.pdf). По моим расчетам, если вероятность отказа диска в этом году составляет, скажем, 4 %, а в хранилище 10 дисков, то вероятность прожить год без неисправностей составляет всего 66 %. О цифрах можно спорить, но факт остается фактом: диски выходят из строя.

RAID (Redundant Array of Individual Disks – избыточный массив отдельных дисков) позволяет создавать хранилища, способные противостоять неисправностям дисков. Существует множество аппаратных дисковых контроллеров RAID, но в Linux также можно создавать программные массивы RAID с помощью стандартных устройств. Прежде чем углубиться в детали, поговорим о концепции «блочного устройства» в Linux. Блочное устройство – устройство хранения, к которому можно адресоваться, а также считывать и записывать данные поблочно. Очевидный пример – жесткий диск, но, как мы увидим, есть и другие. Блочные устройства в Linux важны, потому что на них строится файловая система.

Глубоко в недрах ядра Linux находится «сопоставитель устройств» [device mapper] – система, способная создавать блочные устройства «поверх» других блочных устройств. Она используется для создания программных устройств RAID (наша тема), а также для логических томов и зашифрованных разделов. Существует несколько способов настройки устройств RAID. Рассмотрим три из них.

- Метамодернизм в позднем творчестве В.Г. Сорокина

- ЛитРПГ - последняя отрыжка постмодерна

- "Ричард III и семиотика"

- 3D-визуализация обложки Ridero создаем обложку книги при работе над самиздатом.

- Архитектура метамодерна - говоря о современном искусстве, невозможно не поговорить об архитектуре. В данной статье будет отмечено несколько интересных принципов, характерных для построек "новой волны", столь притягательных и скандальных.

- Литература

- Метамодерн

- Рокер-Прометей против изначального зла в «Песне про советскую милицию» Вени Дркина, Автор: Нина Ищенко, к.ф.н, член Союза Писателей ЛНР - перепубликация из журнала "Топос".

- Как избавиться от комаров? Лучшие типы ловушек.

- Что делать если роблокс вылетает на windows

- Что делать, если ребенок смотрит порно?

- Почему собака прыгает на людей при встрече?

- Какое масло лить в Задний дифференциал (мост) Visco diff 38434AA050

- О чем может рассказать хвост вашей кошки?

- Верветки

- Отчетность бюджетных учреждений при закупках по Закону № 223-ФЗ

- Срок исковой давности как правильно рассчитать

- Дмитрий Патрушев минсельхоз будет ли преемником Путина

- Кто такой Владислав Поздняков? Что такое "Мужское Государство" и почему его признали экстремистским в России?

- Как правильно выбрать машинное масло в Димитровграде?

- Как стать богатым и знаменитым в России?

- Почему фильм "Пипец" (Kick-Ass) стал популярен по всему миру?

- Как стать мудрецом?

- Как правильно установить FreeBSD

- Как стать таким как Путин?

- Где лучше жить - в Димитровграде или в Ульяновске?

- Почему город Димитровград так называется?

- Что такое метамодерн?

- ВАЖНО! Временное ограничение движения автотранспортных средств в Димитровграде

- Тарифы на электроэнергию для майнеров предложено повыситьПрограммный RAID работает лучше всего, когда у вас несколько одинаковых дисков – желательно на отдельных контроллерах. Учтите, что бессмысленно создавать массив RAID из нескольких разделов на одном диске или из нескольких виртуальных дисков в виртуальной машине, потому что все они находятся в одной файловой системе на главных компьютерах. Очевидно, что в обоих случаях у вас есть всего один диск, и избыточности нет.

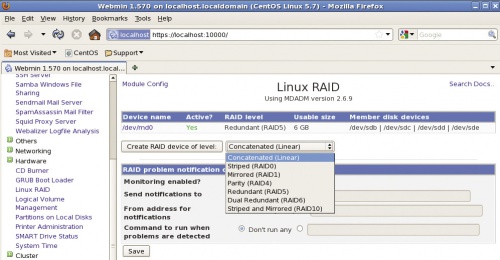

[править] Хорошо, и как это работает в Linux?

Linux поддерживает RAID на уровне сопоставителя устройств внутри ядра, а настраивается RAID утилитой командной строки mdadm, которая позволяет создавать, наращивать и управлять устройствами программного RAID. У этой утилиты масса параметров, и внимательное чтение ее man-страницы может запросто занять целый вечер. В вашей системе она может быть не установлена по умолчанию. Например, в Ubuntu потребуется пакет mdadm:

$ sudo apt-get install mdadm

Рассмотрим пример. Пусть у вас четыре диска (sdb, sdc, sdd и sde), и вы хотите сформировать из них массив RAID 5. Следующая команда сделает всю работу:

# mdadm -C /dev/md0 -n4 /dev/sdb /dev/sdc /dev/sdd /dev/sde -l5

В случае RAID 0 дисковое пространство по сути дела распространяется на несколько дисков, для имитации одного большого диска. Это можно сделать, сцепив диски (данные записываются на первый диск, затем подряд на второй, после того как первый заполнится). При этом диски не обязаны быть одного и того же объема. Можно также чередовать диски (последовательные фрагменты данных записываются на первый диск, затем на второй, затем на третий). Избыточности при любом размещении дисков не возникает. Если один из дисков выходит из строя, вы теряете весь RAID.

RAID 1, также известный как «зеркалирование» – одна из простейших конфигураций RAID. В этом случае используются два диска, и данные просто дублируются на обоих. Диски должны быть одинакового объема. Если один из дисков выйдет из строя, RAID продолжит работу на оставшемся диске. После замены неисправного диска данные просто снова дублируются на него с оставшегося рабочего диска. Это просто и эффективно – недостаток в том, что вам нужно вдвое больше физического места на диске: с парой дисков по 500 ГБ вы получите всего 500 ГБ для хранения данных.

- Метамодернизм в позднем творчестве В.Г. Сорокина

- ЛитРПГ - последняя отрыжка постмодерна

- "Ричард III и семиотика"

- 3D-визуализация обложки Ridero создаем обложку книги при работе над самиздатом.

- Архитектура метамодерна - говоря о современном искусстве, невозможно не поговорить об архитектуре. В данной статье будет отмечено несколько интересных принципов, характерных для построек "новой волны", столь притягательных и скандальных.

- Литература

- Метамодерн

- Рокер-Прометей против изначального зла в «Песне про советскую милицию» Вени Дркина, Автор: Нина Ищенко, к.ф.н, член Союза Писателей ЛНР - перепубликация из журнала "Топос".

- Как избавиться от комаров? Лучшие типы ловушек.

- Что делать если роблокс вылетает на windows

- Что делать, если ребенок смотрит порно?

- Почему собака прыгает на людей при встрече?

- Какое масло лить в Задний дифференциал (мост) Visco diff 38434AA050

- О чем может рассказать хвост вашей кошки?

- Верветки

- Отчетность бюджетных учреждений при закупках по Закону № 223-ФЗ

- Срок исковой давности как правильно рассчитать

- Дмитрий Патрушев минсельхоз будет ли преемником Путина

- Кто такой Владислав Поздняков? Что такое "Мужское Государство" и почему его признали экстремистским в России?

- Как правильно выбрать машинное масло в Димитровграде?

- Как стать богатым и знаменитым в России?

- Почему фильм "Пипец" (Kick-Ass) стал популярен по всему миру?

- Как стать мудрецом?

- Как правильно установить FreeBSD

- Как стать таким как Путин?

- Где лучше жить - в Димитровграде или в Ульяновске?

- Почему город Димитровград так называется?

- Что такое метамодерн?

- ВАЖНО! Временное ограничение движения автотранспортных средств в Димитровграде

- Тарифы на электроэнергию для майнеров предложено повысить

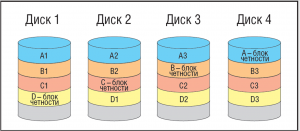

Одна из наиболее часто используемых конфигураций. Как и в RAID 0, в ней используется чередование, но здесь появляется блок четности, который позволяет восстановить содержимое раздела в случае выхода из строя одного из дисков. Блоки четности распределяются по всем дискам. Это сложнее представить в голове, поэтому я нарисовал небольшую картинку. Я не буду производить расчеты, но поверьте: если один диск выйдет из строя, его содержимое можно будет восстановить с оставшихся дисков. Для RAID 5 требуется не менее трех дисков, но такой массив дает хорошее сочетание избыточности (он может выдержать потерю одного диска) и эффективного использования пространства. Например, если у вас массив из пяти дисков, только 20 % пространства «тратится» на хранение избыточной информации.

- Метамодернизм в позднем творчестве В.Г. Сорокина

- ЛитРПГ - последняя отрыжка постмодерна

- "Ричард III и семиотика"

- 3D-визуализация обложки Ridero создаем обложку книги при работе над самиздатом.

- Архитектура метамодерна - говоря о современном искусстве, невозможно не поговорить об архитектуре. В данной статье будет отмечено несколько интересных принципов, характерных для построек "новой волны", столь притягательных и скандальных.

- Литература

- Метамодерн

- Рокер-Прометей против изначального зла в «Песне про советскую милицию» Вени Дркина, Автор: Нина Ищенко, к.ф.н, член Союза Писателей ЛНР - перепубликация из журнала "Топос".

- Как избавиться от комаров? Лучшие типы ловушек.

- Что делать если роблокс вылетает на windows

- Что делать, если ребенок смотрит порно?

- Почему собака прыгает на людей при встрече?

- Какое масло лить в Задний дифференциал (мост) Visco diff 38434AA050

- О чем может рассказать хвост вашей кошки?

- Верветки

- Отчетность бюджетных учреждений при закупках по Закону № 223-ФЗ

- Срок исковой давности как правильно рассчитать

- Дмитрий Патрушев минсельхоз будет ли преемником Путина

- Кто такой Владислав Поздняков? Что такое "Мужское Государство" и почему его признали экстремистским в России?

- Как правильно выбрать машинное масло в Димитровграде?

- Как стать богатым и знаменитым в России?

- Почему фильм "Пипец" (Kick-Ass) стал популярен по всему миру?

- Как стать мудрецом?

- Как правильно установить FreeBSD

- Как стать таким как Путин?

- Где лучше жить - в Димитровграде или в Ульяновске?

- Почему город Димитровград так называется?

- Что такое метамодерн?

- ВАЖНО! Временное ограничение движения автотранспортных средств в Димитровграде

- Тарифы на электроэнергию для майнеров предложено повысить

- Метамодернизм в позднем творчестве В.Г. Сорокина

- ЛитРПГ - последняя отрыжка постмодерна

- "Ричард III и семиотика"

- 3D-визуализация обложки Ridero создаем обложку книги при работе над самиздатом.

- Архитектура метамодерна - говоря о современном искусстве, невозможно не поговорить об архитектуре. В данной статье будет отмечено несколько интересных принципов, характерных для построек "новой волны", столь притягательных и скандальных.

- Литература

- Метамодерн

- Рокер-Прометей против изначального зла в «Песне про советскую милицию» Вени Дркина, Автор: Нина Ищенко, к.ф.н, член Союза Писателей ЛНР - перепубликация из журнала "Топос".

- Как избавиться от комаров? Лучшие типы ловушек.

- Что делать если роблокс вылетает на windows

- Что делать, если ребенок смотрит порно?

- Почему собака прыгает на людей при встрече?

- Какое масло лить в Задний дифференциал (мост) Visco diff 38434AA050

- О чем может рассказать хвост вашей кошки?

- Верветки

- Отчетность бюджетных учреждений при закупках по Закону № 223-ФЗ

- Срок исковой давности как правильно рассчитать

- Дмитрий Патрушев минсельхоз будет ли преемником Путина

- Кто такой Владислав Поздняков? Что такое "Мужское Государство" и почему его признали экстремистским в России?

- Как правильно выбрать машинное масло в Димитровграде?

- Как стать богатым и знаменитым в России?

- Почему фильм "Пипец" (Kick-Ass) стал популярен по всему миру?

- Как стать мудрецом?

- Как правильно установить FreeBSD

- Как стать таким как Путин?

- Где лучше жить - в Димитровграде или в Ульяновске?

- Почему город Димитровград так называется?

- Что такое метамодерн?

- ВАЖНО! Временное ограничение движения автотранспортных средств в Димитровграде

- Тарифы на электроэнергию для майнеров предложено повысить

Теперь на этом устройстве RAID можно создать файловую систему точно так же, как на обычном разделе диска или на любом другом блочном устройстве:

# mke2fs -j /dev/md0

Затем ее можно смонтировать или добавить в /etc/fstab обычным образом.

[править] Делаем изменения постоянными

Устройство RAID /dev/md0, которое мы только что создали, не будет повторно создано после перезагрузки системы, если не добавить соответствующую строку в файл /etc/mdadm.conf. Можно сделать так, чтобы mdadm добавила ее за нас – примерно так:

# mdadm --examine --scan >> /etc/mdadm.conf

Или можно вручную пересоздать устройство RAID:

# mdadm --assemble --scan

[править] Нет новостей — это хорошая новость

Итак, ваш массив RAID жужжит себе помаленьку, но однажды утром один из дисков выходит из строя. К счастью, устройство RAID продолжит функционировать, а сервер продолжит работать: его единственная причина жить – оставаться рабочим в подобных обстоятельствах. Но теперь у вас нет избыточности, и хотя вероятность, что в тот же день выйдет из строя другой диск, мала (с той же вероятностью можно получить второй прокол по дороге в гараж на проколотой шине), вы должны узнать о неисправности, чтобы поскорее заменить поврежденный диск. Для этого можно воспользоваться mdadm в режиме мониторинга. В моей CentOS 5 для этого используется сервис mdmonitor, запускаемый при старте системы. Его можно запустить, скомандовав

# service mdmonitor start

А настроить его запуск при старте системы можно командой

# chkconfig mdmonitor on

В режиме мониторинга mdadm будет наблюдать за состоянием устройств RAID и создавать события, если произойдет что-то важное. События включают DeviceDisappeared, RebuildStarted, RebuildFinished, Fail и FailSpare. Некоторые из этих событий (касающиеся плохих новостей) приведут к том, что на адрес назначения, указанный в mdadm.conf, будет отправлено письмо. Вам понадобится нечто вроде этого:

MAILADDR chris@localhost

Если для отслеживания состояния системы вы пользуетесь утилитой уровня предприятия вроде Nagios, к ней есть модуль расширения для отслеживания состояния устройств RAID. Наверное, не помешает проверить правильность реакции RAID на отказ диска еще до этого отказа. Отказ диска легко имитируется следующим образом:

# mdadm /dev/md0 --fail /dev/sdc mdadm: set /dev/sdc faulty in /dev/md0 Вывод команды mdadm -D теперь дает такие результаты: Number Major Minor RaidDevice State 0 8 16 0 active sync /dev/sdb 1 0 0 1 removed 2 8 48 2 active sync /dev/sdd 3 8 64 3 active sync /dev/sde 4 8 32 - faulty spare /dev/sdc

Если ваш бюджет позволяет вам приобрести лишний диск, можете применить его для «горячей замены», воспользовавшись опцией --spare-devices команды mdadm. Это купит вам ощущение спокойствия. Диски «горячей замены» также можно совместно использовать в нескольких устройствах RAID, поместив их в одну разделяемую группу. Подробнее о программном RAID в Linux расскажут man-страницы mdadm и mdadm.conf; или зайдите на raid.wiki.kernel.org.