LXF164:Скрытая опора CERN

Olkol (обсуждение | вклад) (→БАК – это много данных) |

Olkol (обсуждение | вклад) м (Olkol переименовал страницу LXF164: в LXF164:Скрытая опора CERN) |

||

| (не показаны 5 промежуточных версий 1 участника) | |||

| Строка 30: | Строка 30: | ||

Пауло Калафиура [Paulo Calafiura] – главный архитектор экспериментального ПО ATLAS, и он работает в этом проекте с 2001 года. Тогда ощущение его масштабности многое изменило. | Пауло Калафиура [Paulo Calafiura] – главный архитектор экспериментального ПО ATLAS, и он работает в этом проекте с 2001 года. Тогда ощущение его масштабности многое изменило. | ||

| − | {{Врезка|left|Заголовок=Что такое бозон Хиггса? |Ширина= | + | {{Врезка|right|Заголовок= Словарь CERN|Ширина=20%|Содержание= |

| + | CERN European Organisation for Nuclear Research (Conseil Europe´en pour la Recherche Nucle´aire) – Европейская организация ядерных исследований | ||

| + | |||

| + | ATLAS А Toroidal LHC Apparatus – Тороидальный аппарат БАК | ||

| + | |||

| + | CMS Compact Muon Solenoid – Компактный мюонный соленоид | ||

| + | |||

| + | TOTEM Total Elastic and diffractive cross section Measurement – Общее измерение эластичности и дифракционного сечения | ||

| + | |||

| + | ALICE A Large Ion Collider Experiment – Эксперимент Большого ионного коллайдера | ||

| + | |||

| + | LHCb LHC beauty – Красота БАК | ||

| + | |||

| + | MoEDAL Monopole and exotics Detector At the LHC – Детектор медленных частиц | ||

| + | |||

| + | LHCf LHC Forward | ||

| + | |||

| + | WLCG Worldwide LHC Computing Grid – Всемирная сеть распределенных вычислений БАК | ||

| + | |||

| + | LHC Large Hadron Collider – Большой адронный коллайдер (БАК) }} | ||

| + | {{Врезка|left|Заголовок=Что такое бозон Хиггса? |Ширина=40%|Содержание= | ||

Нас всех очень взволновало сообщение ATLAS и CMS о том, что они обнаружили частицу, которую никто ранее не наблюдал и которая выглядит, как бозон Хиггса, если бы он существовал, но почему? | Нас всех очень взволновало сообщение ATLAS и CMS о том, что они обнаружили частицу, которую никто ранее не наблюдал и которая выглядит, как бозон Хиггса, если бы он существовал, но почему? | ||

| Строка 39: | Строка 59: | ||

Для тех, чье знание квантовой физики сводится в той или иной степени к коту Шредингера: нарушение симметрии – это пункт, в котором ящик открывается и кот обнаруживается живым или мертвым. Без поля Хиггса или без чего-либо подобного ему не могли бы сформироваться более крупные частицы – или объекты вроде нас с вами. | Для тех, чье знание квантовой физики сводится в той или иной степени к коту Шредингера: нарушение симметрии – это пункт, в котором ящик открывается и кот обнаруживается живым или мертвым. Без поля Хиггса или без чего-либо подобного ему не могли бы сформироваться более крупные частицы – или объекты вроде нас с вами. | ||

| − | Бозон Хиггса – нестабильная частица, которая, существуй она, распадалась бы на частицы помельче почти сразу после отделения от столкнувшихся протонов. В результате данные с сенсоров анализируются на предмет наличия структур, указывающих, вместо самой частицы, на наличие частиц, на которые она могла | + | Бозон Хиггса – нестабильная частица, которая, существуй она, распадалась бы на частицы помельче почти сразу после отделения от столкнувшихся протонов. В результате данные с сенсоров анализируются на предмет наличия структур, указывающих, вместо самой частицы, на наличие частиц, на которые она могла распасться – скажем, на два протона, или Z- и W-бозоны. }} |

«Мы были на передовой “больших данных”, – говорит Калафиура. – Когда я впервые сказал, что у нас будет 10 ПБ данных в год, у народа челюсти отвисли. В наши дни Google или Facebook могут без особых усилий сделать это в любом из своих центров обработки данных. Однако в науке мы по-прежнему остаемся лидерами по объему данных». Будучи по специальности программистом, Калафиура имеет богатый опыт работы в области физики. До начала работы в ATLAS он помогал писать GAUDI Framework – это фундамент большинства приложений физики высоких энергий, особенно используемых в CERN. Идея GAUDI заключалась в создании общей платформы для физических исследований, чтобы облегчить сотрудничество ученым всего мира. | «Мы были на передовой “больших данных”, – говорит Калафиура. – Когда я впервые сказал, что у нас будет 10 ПБ данных в год, у народа челюсти отвисли. В наши дни Google или Facebook могут без особых усилий сделать это в любом из своих центров обработки данных. Однако в науке мы по-прежнему остаемся лидерами по объему данных». Будучи по специальности программистом, Калафиура имеет богатый опыт работы в области физики. До начала работы в ATLAS он помогал писать GAUDI Framework – это фундамент большинства приложений физики высоких энергий, особенно используемых в CERN. Идея GAUDI заключалась в создании общей платформы для физических исследований, чтобы облегчить сотрудничество ученым всего мира. | ||

| Строка 49: | Строка 69: | ||

По словам Калафиуры, ноутбуки Apple все чаще встречаются среди участников конференций по физике высоких энергий, но в них очень редко можно встретить кнопку Пуск [Start]. «В своей душе архитектора, – признает он, – я не очень доволен тем, что мы работаем исключительно на Linux, потому что проще решать некоторые проблемы, не будучи зависимым от платформы. Но использование только Linux позволяет нам обойти ряд острых углов. Например, мы обсуждали non-POSIX функцию Linux под названием Splice – это канал, где вы не копируете данные, что повышает эффективность нашей обработки данных». | По словам Калафиуры, ноутбуки Apple все чаще встречаются среди участников конференций по физике высоких энергий, но в них очень редко можно встретить кнопку Пуск [Start]. «В своей душе архитектора, – признает он, – я не очень доволен тем, что мы работаем исключительно на Linux, потому что проще решать некоторые проблемы, не будучи зависимым от платформы. Но использование только Linux позволяет нам обойти ряд острых углов. Например, мы обсуждали non-POSIX функцию Linux под названием Splice – это канал, где вы не копируете данные, что повышает эффективность нашей обработки данных». | ||

| + | |||

| + | ===Сотрудничество в области открытого кода=== | ||

| + | |||

| + | ''Около 10 000 физиков по всему миру работают над проектами, связанными с CERN; две трети из них брошены на крупные эксперименты, ATLAS и CMS.'' | ||

| + | |||

| + | Анализ данных, произведенных БАК – это дерзание на многих уровнях. Предоставление ученым результатов подразумевает массовую передачу данных. Затем встает вопрос обработки этих данных. Надежность – тоже важный аспект: если на сервере где-то посреди процесса произойдет сбой после двухсуточной работы, его перезапуск будет стоит всего ранее затраченного драгоценного времени и усилий. | ||

| + | |||

| + | Сфера обработки и хранения данных в CERN обеспечивается мощным проектом распределенных вычислений внутри одной из самых мощных вычислительных сетей в мире, с самым широким охватом. Точная терминология и реализация WLCG разная в 36 странах и 156 организациях, принимающих участие в проекте, но по сути это – многоуровневая сеть для доступа и ресурсов. В центре этой сети располагается CERN, или Tier 0 (T0), располагающий свыше 28 000 логических CPU для обеспечения распределенных вычислений. T0 – это место, где генерируются необработанные экспериментальные данные. С T0 соединены – чаще всего 10-Gbps волокном – центры Tier 1 (T1), которые обычно располагаются в крупных национальных лабораториях физики высоких энергий и выступают в роли локальных узлов. В большинстве случаев все T1 отражают одни и те же данные, произведенные в CERN. | ||

| + | |||

| + | Ниже центров T1 располагаются центры обработки данных Tier 2 (T2). Как правило, они расположены в крупных университетах, где имеются необходимые ресурсы, чтобы обеспечить свободное место, стойки и как минимум одного сотрудника для работы с ними. Обычно соединение между центрами T1 и T2 осуществляется через национальную академическую сеть (в Великобритании это JANET), и поэтому они имеют высокую скорость, но не специально выделенный трафик. Локально хранятся не все исследовательские данные – скорее, поднаборы данных, представляющие интерес для определенной организации, будут находится на постоянном хранении, а остальные данные будут по мере надобности браться в T1. | ||

| + | |||

| + | Учреждения Tier 3 (T3) – это, как правило, менее масштабные университеты и исследовательские центры, которым не требуются отдельно выделенные для работы местные ресурсы, но которые, согласно требованиям, скачивают данные из сети T2 и обеспечивают их обработку в сети распределенных вычислений. | ||

| + | |||

| + | Существует несколько информационных онлайн-панелей, куда каждый может зайти и увидеть состояние сети (самые информативные – http://dashb-wlcg-transfers.cern.ch/ui/, https://netstat.cern.ch/monitoring/network-statistics/visual/?p=ge и http://wlcg.web.cern.ch/. В настоящий момент имеется около 90 000 физических CPU на 345 893 логических ядрах, соединенных с WLCG. Общая емкость хранения составляет 300 ПБ. В Великобритании национальный проект распределенных вычислений WLCG известен как GridPP, и управляет им из Университета Оксфорда Пит Гронбаx [Pete Gronbach]. Согласно карте сети – www.gridpp.ac.uk – с GridPP соединено более 37 000 логических ядер CPU, и все это работает как единый ресурс для ученых, занимающихся аналитикой на основе данных CERN. | ||

| + | |||

| + | «Мы постоянно проводим мониторинг системы, убеждаясь, что наши сервисы работают нормально, – объясняет Гронбаx. – Если вы потерпели неудачу в каком-либо тесте, это отображается на контрольной панели, и ответственные за мониторинг наблюдают за такими вещами и присваивают таким центрам талон неисправности. Есть протокол, согласно которому центр, чтобы быть частью сети, обязан обеспечивать определенный уровень услуг, и неисправность должна быть устранена за оговоренное время. Все делается на очень профессиональном уровне – возможно, вы не ждали такого от университета. Но это не та вещь, с которой мы можем шутить». | ||

| + | |||

| + | Одно из требований для центра T2 –наличие работника с полной занятостью, чья обязанность – поддерживать ресурсы сети, и еженедельно проводятся видео- или аудиоконференции между сисадминами WLCG, чтобы обеспечить корректную работу всей сети и своевременное обновление ее ресурсов. | ||

| + | |||

| + | Крайне важно, что Linux позволяет центрам HEP снизить расходы, поскольку можно использовать более или менее общие компоненты во всей сети обработки и хранения данных. CERN – огромное общественное вложение, более миллиарда евро ежегодно, и он должен уметь считать деньги. Это также означает, что CERN может поддерживать ПО с открытым кодом, типа Disk Pool Manager (DPM), применяемое для поддержки кластеров хранения. Как и следует ожидать от организации, подарившей человечеству Всемирную паутину, она отлично осознает все преимущества совместной разработки. | ||

| + | {{Врезка|right|Заголовок= Генератор ускорителя|Ширина=40%|Содержание= | ||

| + | Вопрос о том, сколько на самом деле данных генерируется БАК, может отчасти ввести в заблуждение, и на него трудно дать точный ответ. В той же бесхитростной манере, что и частицы, за которыми ведется наблюдение, большая их часть исчезает в считанные секунды, когда происходит событие. | ||

| + | |||

| + | В команде ATLAS одной из главных ролей д-ра Сальваторе является участие в группе, работающей над «триггерной» программой для эксперимента. | ||

| + | |||

| + | «Эксперимент состоит их двух пучков протонов, которые сталкиваются каждые 25 наносекунд, и из этого взаимодействия что-то должно получиться, – говорит Сальваторе. – И надо решить, представляет это что-то интерес или нет. Все, что у нас есть – это 40-МГц взаимодействия, но у нас нет возможности хранить 40 МГц данных – мы сохраняем порядка 400 Гц. Частота выборки не переводится непосредственно в байты, на принцип заключается в том, что изначальный набор данных может уменьшиться по объему в тысячу раз». | ||

| + | |||

| + | «Есть три уровня программ, – продолжает Сальваторе, – и первый должен работать в несколько первых микросекунд и вплоть до третьего уровня, который решает, представляет все событие интерес или нет. Задача “Триггера” – быстро провести приблизительный анализ данных и убедиться, что сохраняемые данные представляют интерес, а не являются просто еще одним столкновением. То, что не выбирается из 40 MГц, оказывается потерянным. Перед началом эксперимента мы проводили длительное моделирование по методу Монте-Карло, чтобы посмотреть, что может случиться во время события, и иметь возможность настроить триггер и извлечь из данных все по максимуму». }} | ||

| + | «GridPP существует более 10 лет, – говорит Гронбаx, – но многие пакетные системы остались теми же: мы используем TORQUE и MAUI, на базе PBS. Один-два центра используют Grid Engine, но для него поддержка не распространена. Такие вещи практически неизменны долгие годы. Другие части ПО, такие, как Computing Element (это элемент, сидящий между входящими задачами пользователя и их отправкой в пакетную систему обработки), уже прошли через множество поколений, и мы обновляем их примерно раз в полгода». | ||

| + | |||

| + | По словам Калафиуры, многоядерная обработка данных стала самым значимым лучшением сети распределенных вычислений. | ||

| + | |||

| + | «Благодаря многоядерной обработке, – говорит он, – мы смогли использовать специфическую хитрость Linux – ответвить, скопировать и записать – для запуска восьми или 16 копий одного и того же приложения». | ||

| + | |||

| + | Сейчас основное обновление, происходящее в GridPP – установка Scientific Linux 6 (SL6) и свежей версии Lustre для хранения файловых систем. SL совместно поддерживается CERN и американской лабораторией Fermilab. На момент писания нашей статьи SL6 работает на 99 365 компьютерах – это ниже нормы, видимо, из-за летних каникул в большинстве стран северного полушария. https://www.scientificlinux.org/about/stats/2012/arch.html | ||

| + | |||

| + | SL6 – ответвление Red Hat Enterprise Linux, выбранное за его невероятную стабильность. Не все исследователи применяют SL, и все инструменты, жизненно важные для работы CERN, совместимы с другими дистрибутивами – по-прежнему популярен Ubuntu. Но на всех серверах, соединенных с WLCG, версия SL5 или выше. «Что порадовало за последние 10 лет – это автоматическая установка и администрирование этих систем, – продолжает Гронбах. – Мы можем устанавливать системы, используя Pixiboot, Kickstart, CF Engine или Puppet для быстрой или удаленной переустановки узла, потому что компьютерные центры часто располагаются вне университета». | ||

| + | |||

| + | Унификация оборудования и отлаженное FOSS также облегчает многим центрам выход онлайн и возможность предложить свои ресурсы сети. В июне Сассекс стал центром T2. Университет присоединился к проекту ATLAS в 2009 году, когда д-р Сальваторе и д-р Антонелла Де Санто [Antonella De Santo] вошли в проект от Университета Роял Холлоуэй [Royal Holloway], еще одного центра T2, создав группу ATLAS. Благодаря их работе Сассекс получил финансирование, так что д-р Сальваторе, д-р Де Санто и кафедра ИТ смогли создать центр обработки данных на 12 стоек, со 100 CPU и 150 TБ хранимых данных, в зале с естественным охлаждением, затратив 80 000 фунтов. | ||

| + | |||

| + | ===Углубимся в детали=== | ||

| + | |||

| + | Помимо управления пакетной обработкой данных для тысяч результатов, ежедневно поступающих в WLCG HEP, процесс научного исследования экспериментальных данных также требует подхода, основанного на открытом коде. Все участники эксперимента отвечают за постоянное улучшение программы в плане ее способности выделить значительные события среди миллиардов частиц. | ||

| + | |||

| + | Нет ничего невозможного в том, чтобы быть физиком и при этом не разбираться C++ и не знать, как оптимизировать код с помощью компилятора, но это входит в программу обучения в Сассексе и других учреждениях HEP. | ||

| + | |||

| + | «Наше сообщество было сообществом открытого кода задолго до того, как оно получило это название, – говорит Берд. – Мы используем коммерческое ПО там, где это нужно и можно, но все программы для анализа наших собственных данных написаны у нас же, потому что для выполнения такой работы больше ничего не существует». | ||

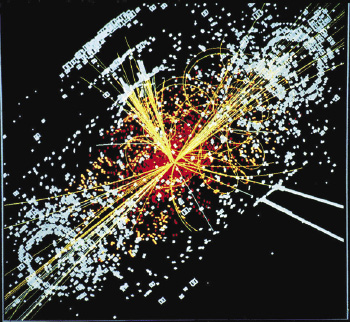

| + | [[Файл:LXF164.feat_cern.15_opt.jpeg | |thumb|400px|> Это не съемки web-камерой знаменитого пятничного турнира CERN по Quake. Это установка рекорда энергии для БАК в ноябре 2009 года — двойной пучок достиг показателя 1,18 TэВ.]] | ||

| + | Величина и сложность ATLAS и CMS означает наличие сотен профессионалов в области ПО, работающих над созданием и поддержкой кода, но, поскольку разные центры занимаются разными частями эксперимента, такие инструменты, как SVN, жизненно важны для управления работой над каждым алгоритмом. «Вы не смогли бы сделать этого в другой операционной системе, – говорит д-р Сальваторе. – С инструментами вроде SVN проще работать изнутри ОС, и мы это определенно эксплуатируем, как можно глубже проникая в ОС; в проприетарных же системах ОС скрыта за несколькими уровнями». | ||

| + | |||

| + | Однако управление результатами работы тысяч академиков HEP – это задача, требующая не просто управления версиями. «Здесь присутствует и некая доля социологии, – говорит Калафиура. – При наличии 3000 участников нужны особые процедуры, чтобы выяснить, кто является членом ATLAS, а кто подписывает документ о Хиггсе. Существует система кредитов. Традиционно это либо работа с детектором, либо разработка программ. Если у кого-то есть хороший алгоритм для отслеживания движения частицы по детектору, они тратят несколько лет на совершенствование этого алгоритма и передают его в общий программный репозиторий, и он становится частью официальных инструкций. До 2010 года большая часть вклада в развитие ПО была сделана физиками, и только в области ядра трудились профессионалы. А затем все изменил тот момент, когда начали поступать реальные данные. В течение нескольких последних лет физики используют инструменты, подготовленные куда меньшим сообществом. Я занимаюсь физикой высоких энергий большую часть своей жизни, и каждый раз, когда эксперимент начинает предоставлять данные, большая часть сообщества сразу теряет всякий интерес к техническому аспекту». | ||

| + | |||

| + | Зачастую исследования начинаются с того, что физики разрабатывают теоретическую базу для расчета результатов события, в котором появится бозон Хиггса. Как только ученый предлагает определенный сценарий, начинаются попытки смоделировать его, используя Monte Carlo, программу, работающую на основе сети распределенных вычислений, которая пытается спрогнозировать, что произойдет при столкновении протонов. Результаты сравниваются с базой данных реальных результатов, чтобы выяснить, кто будет проводить дальнейшие исследования. Событие, в котором выявляется вероятность появления частицы Хиггса, появляется из набора данных, состоящего примерно из квадриллиона столкновений. Есть группы ученых и разработчиков ПО, связанные с каждой частью «основных» компьютерных ресурсов, которые управляют поведением БАК и основным отбором данных. | ||

| + | |||

| + | ===Будущее=== | ||

| + | |||

| + | Поскольку в конце года БАК будет отключен на модернизацию, естественно, что в высших эшелонах проекта вычислений шло немало дебатов по поводу того, чем будет заниматься WLCG, чтобы соответствовать возросшим требованиям экспериментов в области физики высоких энергий. | ||

| + | |||

| + | «Когда мы начали всю эту работу, – говорит Берд, – нас беспокоила сеть, получение достаточной скорости передачи и надежность всего этого. Все получилось просто фантастическим и превзошло все ожидания. Поэтому сегодня вопрос звучит так: “Как нам использовать сеть еще лучше?” Мы ищем более разумные способы использования сети, кэширования и передачи данных, когда того потребует работа, вместо попыток выяснить, где они потребуются». | ||

| + | |||

| + | Неизбежно возникает тема облачных вычислений. Нечто вроде EC2, например, непрактично для повседневного использования, из-за высокой стоимости передачи данных с и на серверы Amazon. Однако он может пригодиться для добавочных вычислений во время проведения основных конференций, поскольку на них всегда есть спрос, когда ученые работают над завершением своих статей и уточнением результатов. Большинство кластеров сети предназначены для 90 % использования своих ресурсов при обычных обстоятельствах, и в них недостаточно свободных циклов, которые можно было бы задействовать. | ||

| + | {{Врезка|left|Заголовок= Запуск сети распределенных вычислений|Ширина=50%|Содержание= | ||

| + | Ян Берд, руководитель проекта CERN WLCG, рассказывает о появлении сети: | ||

| + | |||

| + | «В конце 90-х существовали группы людей, которые собирались и пытались разобраться с тем, какого масштаба вычисления нужны БАК. Были предложены некоторые модели, благодаря которым мы осознали, что у CERN нет собственных возможностей для обеспечения достаточного объема ресурсов для требуемого уровня вычислений и хранения данных. И было создано несколько моделей распределенных вычислений и их работы. | ||

| + | |||

| + | Как раз в тот момент, когда разрабатывались эти модели – около 2000/2001 – появилась эта штука под названием “grid-вычисления”, которая вышла из сообщества компьютерных дисциплин, и показалась неплохим способом реализации модели распределенных вычислений, которую предложили мы. Несколько лет мы занимались созданием прототипа, чтобы выяснить, сумеем ли мы добиться таких вычислений, которые будут делать то, что нам требуется. | ||

| + | |||

| + | Это все переросло в проект LCG, который формально появился в 2002 году; примерно в то же время я приступил к работе в CERN, а за этим последовали семь лет разработок и отладки технологии. | ||

| + | |||

| + | Работая с этими технологиями в требуемом для нашей деятельности масштабе, не имеешь права на неудачу, потому что на них было затрачено невероятное количество времени и усилий. Они должны быть надежными и достаточно масштабными, чтобы соответствовать уровню всех проблем производственного уровня реального мира – и это на самом деле раздвигало границы того, что на тот момент могло делать ПО. В основном мы начинали с нуля, и у нас ушло на это десять лет. Но использовали мы его “по-настоящему” с самого начала, чтобы проводить моделирование и т. п., и это отлично выучило нас создавать надежные программы.}} | ||

| + | «С использованием коммерческих облаков есть проблемы – оно обходится значительно дороже, чем мы можем сделать сами, – говорит Берд. – С другой стороны, имеются такие технологии, как OpenStack, которые крайне интересны. Сейчас мы используем пилотный кластер OpenStack, который позволяет нам предлагать разные виды сервисов и дает возможность применять другой способ соединения центров обработки данных – это не совсем то, что нам нужно, но мы стараемся идти в ногу с технологиями, чтобы не застаиваться, не вязнуть в болоте, занимаясь тем, чем больше никто не занимается». | ||

| + | |||

| + | Столь же горячей темой для обсуждения среди разработчиков ATLAS является GPGPU. «Некоторые академики, например, в Глазго, рассматривают возможность портирования своего кода в GPGPU, – говорит Гронбах из GridPP, – но вопрос в том, соответствует ли тип анализа, который они делают, данному типу обработки данных. Большая часть нашего кода является тем, что известно под названием “усложненного параллелизма”, мы можем нарезать события и данные на порции и отправить каждую из этих порций на отдельный CPU, и ему незачем знать, как решаются другие задачи. Но сама по себе эта задача не параллельная; она не очень хорошо вписывается в обработку данных типа GPU». | ||

| + | |||

| + | По словам Берда, большой интерес вызывает ожидаемое оборудование Intel Larabee/Xeon Phi. | ||

| + | |||

| + | И хотя по поводу развития самой крупной в мире сети распределенных вычислений ведутся оживленные дебаты, можно со всей определенностью сказать, что работа CERN будет продолжаться, и будет становиться все более требовательной каждый год. Существование бозона Хиггса пока не подтверждено, цель Большого адронного коллайдера пока не достигнута и не является единственной задачей, над которой он работает. Это всего лишь первый крупный анонс множества – будем надеяться – грядущих событий. | ||

| + | |||

| + | Поэтому в следующий раз, любуясь звездами и предаваясь философским размышлениям о том, как же все это началось, помните, что все наши недавно полученные знания о жизни, Вселенной и обо всем остальном – это результат труда тысяч ученых и некого замечательного пингвина. | | ||

Текущая версия на 04:05, 28 октября 2018

|

|

|

Содержание |

[править] Скрытая опора CERN

Адам Оксфорд выясняет, как Linux помогает охотиться за бозоном Хиггса.

Обычный день доктора Фабрицио Сальваторе [Fabrizio Salvatore] складывается примерно таким образом: кофе, короткий брифинг с двумя кандидатами наук, работающими на его кафедре в университете Сассекса [University of Sussex], в зеленом кампусе Брайтона. После этого – немного более продолжительная встреча с парой аспирантов, занимающихся исследованиями, а потом – обычные преподавательские дела и обязанности. Весьма типичный академический день.

Если же д-р Сальваторе улучит время на собственное исследование, он начнет с того, что загрузит программу под названием ROOT в свой ноутбук с Ubuntu. ROOT – излюбленная программная среда для физики высоких энергий (HEP) и анализа частиц. Раз в неделю он проводит конференцию по телефону со своими сотрудниками по исследованию по всему миру.

В один действительно прекрасный день – возможно, это случится один-единственный раз за всю его жизнь – он подпишет бумагу об обнаружении почти стопроцентного доказательства существования бозона Хиггса, так называемой частицы Бога, которая придает остальным частицам массу и, таким образом, создает реальность именно в том виде, в котором она существует.

Д-р Сальваторе – один из 3300 ученых, работающих в ATLAS, проекте, включающем создание, обработку и анализ данных от Большого адронного коллайдера (БАК) во всемирно известной швейцарской лаборатории, CERN. «Когда я впервые попал в CERN в 1994 году, – говорит д-р Сальваторе, – это было мое первое пребывание за границей. И моя работа здесь – а длилась она всего месяц – убедила меня в том, что я хочу работать над чем-то, связанным с ней. Я знал, что буду работать над кандидатской в области физики частиц, и знал, что хочу заниматься этим именно здесь».

В июне этого года ученые из ATLAS и их коллеги из CMS, другого эксперимента CERN, объявили о том, что они обнаружили вероятное доказательство существования бозона Хиггса, важной субатомной частицы, чье существование предполагалось чисто теоретически на протяжении полвека, но которой никто не наблюдал. Эту новость окрестили «одним из самых важных научных открытий всех времен», и сделал это не кто иной, как секс-символ научной сферы, профессор Брайан Кокс [Brian Cox]. И – отложим в сторону такую мелочь, как само создание БАК – Хиггс был обнаружен почти целиком и полностью с помощью Linux. На самом деле, многие из тех ученых, с которыми мы беседовали, сказали, что иначе сделать это было бы невозможно.

Интерес общественности к работе CERN неудивителен. Невозможно остаться равнодушным при разговорах об ускорителях частиц, квантовой механике и воссоздании того состояния, в котором пребывала Вселенная в самом начале времен, даже если вы не понимаете того, что на самом деле означают понятия супер-симметрии и элементарной частицы. Внутри коллайдера протоны направляются друг на друга со скоростью, близкой к скорости света. Они пролетают порядка 17 миль замкнутого пространства под Франко-Швейцарскими Альпами, и субатомные осколки их столкновений фиксируются одним или несколькими из семи детекторов, размещенных по периметру кольца. ATLAS и CMS – только два из них.

И невероятное физическое явление столкновения двух протонов – это лишь начало напряженной работы; именно то, что происходит потом, требует наличия одного из крупнейших в мире компьютерных проектов с открытым кодом.

[править] БАК – это много данных

Эксперименты или «события» в БАК дают массу информации. Даже после отбрасывания 90 % данных, полученных его сенсорами, по изначальным приблизительным подсчетам, для хранения данных от коллайдера потребуется порядка 15 петабайт ежегодно. В 2011 году коллайдер предоставил около 23 петабайт данных для анализа, а в 2012-м ожидается, что эта цифра вырастет до 30 ПБ, то есть в два раза превзойдет изначально планируемый показатель. Этой зимой ускоритель закроется на 20 месяцев на ремонт и модернизацию, что приведет к еще большему увеличению объема данных, полученных в результате экспериментов.

Вот эти цифры и есть продукт: тестируя результаты, физики не работают исключительно с последними данными. Событие внутри коллайдера никогда не рассматривается изолированно, но всегда считается частью целого. Сбор данных от БАК, их распределение и тестирование – колоссальная задача. «Самое главное испытание для нас при компьютерной обработке данных, – объясняет Ян Берд [Ian Bird], руководитель проекта Worldwide LHC Computing Grid, – это поиск ресурсов, которые понадобятся для эксперимента в будущем, потому что и объем данных, и требования к их обработке будут все время повышаться, а экономическая ситуация такова, что финансирование сильно не увеличить».

Проводя параллель, можно сказать, что Google ежедневно обрабатывает около 25 ПБ. Но при этом Google не анализирует каждый пиксель в каждой букве каждого слова, помещаемого в архивы, из-за того, что в нем зарегистрирована подпись основной частицы, которую покамест никто не наблюдал.

«То, чем мы занимаемся, не похоже на то, чем занимаются остальные, – говорит Берд. – Скажем, скачав видео, вы получите немало данных, но большинство, скорее всего, просто посмотрит десять первых файлов, и их можно сохранить в кэше, чтобы ускорить обработку. Наша проблема в том, что мы работаем с колоссальными наборами данных, и физикам нужен весь набор целиком. Им нужны не первые четыре гигабайта этого набора, а все 2,5 ПБ – так же, как и тысяче других исследователей. И вы не можете использовать обычную коммерческую сеть передачи данных для решения этой проблемы».

Пауло Калафиура [Paulo Calafiura] – главный архитектор экспериментального ПО ATLAS, и он работает в этом проекте с 2001 года. Тогда ощущение его масштабности многое изменило.

- Метамодернизм в позднем творчестве В.Г. Сорокина

- ЛитРПГ - последняя отрыжка постмодерна

- "Ричард III и семиотика"

- 3D-визуализация обложки Ridero создаем обложку книги при работе над самиздатом.

- Архитектура метамодерна - говоря о современном искусстве, невозможно не поговорить об архитектуре. В данной статье будет отмечено несколько интересных принципов, характерных для построек "новой волны", столь притягательных и скандальных.

- Литература

- Метамодерн

- Рокер-Прометей против изначального зла в «Песне про советскую милицию» Вени Дркина, Автор: Нина Ищенко, к.ф.н, член Союза Писателей ЛНР - перепубликация из журнала "Топос".

- Как избавиться от комаров? Лучшие типы ловушек.

- Что делать если роблокс вылетает на windows

- Что делать, если ребенок смотрит порно?

- Почему собака прыгает на людей при встрече?

- Какое масло лить в Задний дифференциал (мост) Visco diff 38434AA050

- О чем может рассказать хвост вашей кошки?

- Верветки

- Отчетность бюджетных учреждений при закупках по Закону № 223-ФЗ

- Срок исковой давности как правильно рассчитать

- Дмитрий Патрушев минсельхоз будет ли преемником Путина

- Кто такой Владислав Поздняков? Что такое "Мужское Государство" и почему его признали экстремистским в России?

- Как правильно выбрать машинное масло в Димитровграде?

- Как стать богатым и знаменитым в России?

- Почему фильм "Пипец" (Kick-Ass) стал популярен по всему миру?

- Как стать мудрецом?

- Как правильно установить FreeBSD

- Как стать таким как Путин?

- Где лучше жить - в Димитровграде или в Ульяновске?

- Почему город Димитровград так называется?

- Что такое метамодерн?

- ВАЖНО! Временное ограничение движения автотранспортных средств в Димитровграде

- Тарифы на электроэнергию для майнеров предложено повысить

- Метамодернизм в позднем творчестве В.Г. Сорокина

- ЛитРПГ - последняя отрыжка постмодерна

- "Ричард III и семиотика"

- 3D-визуализация обложки Ridero создаем обложку книги при работе над самиздатом.

- Архитектура метамодерна - говоря о современном искусстве, невозможно не поговорить об архитектуре. В данной статье будет отмечено несколько интересных принципов, характерных для построек "новой волны", столь притягательных и скандальных.

- Литература

- Метамодерн

- Рокер-Прометей против изначального зла в «Песне про советскую милицию» Вени Дркина, Автор: Нина Ищенко, к.ф.н, член Союза Писателей ЛНР - перепубликация из журнала "Топос".

- Как избавиться от комаров? Лучшие типы ловушек.

- Что делать если роблокс вылетает на windows

- Что делать, если ребенок смотрит порно?

- Почему собака прыгает на людей при встрече?

- Какое масло лить в Задний дифференциал (мост) Visco diff 38434AA050

- О чем может рассказать хвост вашей кошки?

- Верветки

- Отчетность бюджетных учреждений при закупках по Закону № 223-ФЗ

- Срок исковой давности как правильно рассчитать

- Дмитрий Патрушев минсельхоз будет ли преемником Путина

- Кто такой Владислав Поздняков? Что такое "Мужское Государство" и почему его признали экстремистским в России?

- Как правильно выбрать машинное масло в Димитровграде?

- Как стать богатым и знаменитым в России?

- Почему фильм "Пипец" (Kick-Ass) стал популярен по всему миру?

- Как стать мудрецом?

- Как правильно установить FreeBSD

- Как стать таким как Путин?

- Где лучше жить - в Димитровграде или в Ульяновске?

- Почему город Димитровград так называется?

- Что такое метамодерн?

- ВАЖНО! Временное ограничение движения автотранспортных средств в Димитровграде

- Тарифы на электроэнергию для майнеров предложено повысить

«Мы были на передовой “больших данных”, – говорит Калафиура. – Когда я впервые сказал, что у нас будет 10 ПБ данных в год, у народа челюсти отвисли. В наши дни Google или Facebook могут без особых усилий сделать это в любом из своих центров обработки данных. Однако в науке мы по-прежнему остаемся лидерами по объему данных». Будучи по специальности программистом, Калафиура имеет богатый опыт работы в области физики. До начала работы в ATLAS он помогал писать GAUDI Framework – это фундамент большинства приложений физики высоких энергий, особенно используемых в CERN. Идея GAUDI заключалась в создании общей платформы для физических исследований, чтобы облегчить сотрудничество ученым всего мира.

До GAUDI, по словам Калафиуры, большинство программ для анализа обычно писались по мере надобности на языке FORTRAN. Благодаря переходу на объектно-ориентированную среду для сбора данных, моделирования и анализа с использованием C++, команда, в которой работал Калафиура, заложила основы широкомасштабного глобального сотрудничества на основе работы CERN.

«Среда GAUDI определенно является мультиплатформенной, – говорит Калафиура. – Сначала программа ATLAS поддерживалась рядом платформ Unix, а GAUDI поддерживала – и поддерживает – Windows. Примерно в 2005 году мы отключили сборку Solaris [из-за отсутствия интереса], а до этого большая часть оборудования работала на HPUX. Но серверы перешли на Linux, и все были довольны».

«В данный момент, – продолжает Калафиура, – с точки зрения настоящих компьютерных технологий и разработки прикладных программ мы являемся в чистом виде мастерской Linux. Растет число тех, кто ратует за MacOS, но работа ведется на самой лучшей основе».

По словам Калафиуры, ноутбуки Apple все чаще встречаются среди участников конференций по физике высоких энергий, но в них очень редко можно встретить кнопку Пуск [Start]. «В своей душе архитектора, – признает он, – я не очень доволен тем, что мы работаем исключительно на Linux, потому что проще решать некоторые проблемы, не будучи зависимым от платформы. Но использование только Linux позволяет нам обойти ряд острых углов. Например, мы обсуждали non-POSIX функцию Linux под названием Splice – это канал, где вы не копируете данные, что повышает эффективность нашей обработки данных».

[править] Сотрудничество в области открытого кода

Около 10 000 физиков по всему миру работают над проектами, связанными с CERN; две трети из них брошены на крупные эксперименты, ATLAS и CMS.

Анализ данных, произведенных БАК – это дерзание на многих уровнях. Предоставление ученым результатов подразумевает массовую передачу данных. Затем встает вопрос обработки этих данных. Надежность – тоже важный аспект: если на сервере где-то посреди процесса произойдет сбой после двухсуточной работы, его перезапуск будет стоит всего ранее затраченного драгоценного времени и усилий.

Сфера обработки и хранения данных в CERN обеспечивается мощным проектом распределенных вычислений внутри одной из самых мощных вычислительных сетей в мире, с самым широким охватом. Точная терминология и реализация WLCG разная в 36 странах и 156 организациях, принимающих участие в проекте, но по сути это – многоуровневая сеть для доступа и ресурсов. В центре этой сети располагается CERN, или Tier 0 (T0), располагающий свыше 28 000 логических CPU для обеспечения распределенных вычислений. T0 – это место, где генерируются необработанные экспериментальные данные. С T0 соединены – чаще всего 10-Gbps волокном – центры Tier 1 (T1), которые обычно располагаются в крупных национальных лабораториях физики высоких энергий и выступают в роли локальных узлов. В большинстве случаев все T1 отражают одни и те же данные, произведенные в CERN.

Ниже центров T1 располагаются центры обработки данных Tier 2 (T2). Как правило, они расположены в крупных университетах, где имеются необходимые ресурсы, чтобы обеспечить свободное место, стойки и как минимум одного сотрудника для работы с ними. Обычно соединение между центрами T1 и T2 осуществляется через национальную академическую сеть (в Великобритании это JANET), и поэтому они имеют высокую скорость, но не специально выделенный трафик. Локально хранятся не все исследовательские данные – скорее, поднаборы данных, представляющие интерес для определенной организации, будут находится на постоянном хранении, а остальные данные будут по мере надобности браться в T1.

Учреждения Tier 3 (T3) – это, как правило, менее масштабные университеты и исследовательские центры, которым не требуются отдельно выделенные для работы местные ресурсы, но которые, согласно требованиям, скачивают данные из сети T2 и обеспечивают их обработку в сети распределенных вычислений.

Существует несколько информационных онлайн-панелей, куда каждый может зайти и увидеть состояние сети (самые информативные – http://dashb-wlcg-transfers.cern.ch/ui/, https://netstat.cern.ch/monitoring/network-statistics/visual/?p=ge и http://wlcg.web.cern.ch/. В настоящий момент имеется около 90 000 физических CPU на 345 893 логических ядрах, соединенных с WLCG. Общая емкость хранения составляет 300 ПБ. В Великобритании национальный проект распределенных вычислений WLCG известен как GridPP, и управляет им из Университета Оксфорда Пит Гронбаx [Pete Gronbach]. Согласно карте сети – www.gridpp.ac.uk – с GridPP соединено более 37 000 логических ядер CPU, и все это работает как единый ресурс для ученых, занимающихся аналитикой на основе данных CERN.

«Мы постоянно проводим мониторинг системы, убеждаясь, что наши сервисы работают нормально, – объясняет Гронбаx. – Если вы потерпели неудачу в каком-либо тесте, это отображается на контрольной панели, и ответственные за мониторинг наблюдают за такими вещами и присваивают таким центрам талон неисправности. Есть протокол, согласно которому центр, чтобы быть частью сети, обязан обеспечивать определенный уровень услуг, и неисправность должна быть устранена за оговоренное время. Все делается на очень профессиональном уровне – возможно, вы не ждали такого от университета. Но это не та вещь, с которой мы можем шутить».

Одно из требований для центра T2 –наличие работника с полной занятостью, чья обязанность – поддерживать ресурсы сети, и еженедельно проводятся видео- или аудиоконференции между сисадминами WLCG, чтобы обеспечить корректную работу всей сети и своевременное обновление ее ресурсов.

Крайне важно, что Linux позволяет центрам HEP снизить расходы, поскольку можно использовать более или менее общие компоненты во всей сети обработки и хранения данных. CERN – огромное общественное вложение, более миллиарда евро ежегодно, и он должен уметь считать деньги. Это также означает, что CERN может поддерживать ПО с открытым кодом, типа Disk Pool Manager (DPM), применяемое для поддержки кластеров хранения. Как и следует ожидать от организации, подарившей человечеству Всемирную паутину, она отлично осознает все преимущества совместной разработки.

- Метамодернизм в позднем творчестве В.Г. Сорокина

- ЛитРПГ - последняя отрыжка постмодерна

- "Ричард III и семиотика"

- 3D-визуализация обложки Ridero создаем обложку книги при работе над самиздатом.

- Архитектура метамодерна - говоря о современном искусстве, невозможно не поговорить об архитектуре. В данной статье будет отмечено несколько интересных принципов, характерных для построек "новой волны", столь притягательных и скандальных.

- Литература

- Метамодерн

- Рокер-Прометей против изначального зла в «Песне про советскую милицию» Вени Дркина, Автор: Нина Ищенко, к.ф.н, член Союза Писателей ЛНР - перепубликация из журнала "Топос".

- Как избавиться от комаров? Лучшие типы ловушек.

- Что делать если роблокс вылетает на windows

- Что делать, если ребенок смотрит порно?

- Почему собака прыгает на людей при встрече?

- Какое масло лить в Задний дифференциал (мост) Visco diff 38434AA050

- О чем может рассказать хвост вашей кошки?

- Верветки

- Отчетность бюджетных учреждений при закупках по Закону № 223-ФЗ

- Срок исковой давности как правильно рассчитать

- Дмитрий Патрушев минсельхоз будет ли преемником Путина

- Кто такой Владислав Поздняков? Что такое "Мужское Государство" и почему его признали экстремистским в России?

- Как правильно выбрать машинное масло в Димитровграде?

- Как стать богатым и знаменитым в России?

- Почему фильм "Пипец" (Kick-Ass) стал популярен по всему миру?

- Как стать мудрецом?

- Как правильно установить FreeBSD

- Как стать таким как Путин?

- Где лучше жить - в Димитровграде или в Ульяновске?

- Почему город Димитровград так называется?

- Что такое метамодерн?

- ВАЖНО! Временное ограничение движения автотранспортных средств в Димитровграде

- Тарифы на электроэнергию для майнеров предложено повысить

«GridPP существует более 10 лет, – говорит Гронбаx, – но многие пакетные системы остались теми же: мы используем TORQUE и MAUI, на базе PBS. Один-два центра используют Grid Engine, но для него поддержка не распространена. Такие вещи практически неизменны долгие годы. Другие части ПО, такие, как Computing Element (это элемент, сидящий между входящими задачами пользователя и их отправкой в пакетную систему обработки), уже прошли через множество поколений, и мы обновляем их примерно раз в полгода».

По словам Калафиуры, многоядерная обработка данных стала самым значимым лучшением сети распределенных вычислений.

«Благодаря многоядерной обработке, – говорит он, – мы смогли использовать специфическую хитрость Linux – ответвить, скопировать и записать – для запуска восьми или 16 копий одного и того же приложения».

Сейчас основное обновление, происходящее в GridPP – установка Scientific Linux 6 (SL6) и свежей версии Lustre для хранения файловых систем. SL совместно поддерживается CERN и американской лабораторией Fermilab. На момент писания нашей статьи SL6 работает на 99 365 компьютерах – это ниже нормы, видимо, из-за летних каникул в большинстве стран северного полушария. https://www.scientificlinux.org/about/stats/2012/arch.html

SL6 – ответвление Red Hat Enterprise Linux, выбранное за его невероятную стабильность. Не все исследователи применяют SL, и все инструменты, жизненно важные для работы CERN, совместимы с другими дистрибутивами – по-прежнему популярен Ubuntu. Но на всех серверах, соединенных с WLCG, версия SL5 или выше. «Что порадовало за последние 10 лет – это автоматическая установка и администрирование этих систем, – продолжает Гронбах. – Мы можем устанавливать системы, используя Pixiboot, Kickstart, CF Engine или Puppet для быстрой или удаленной переустановки узла, потому что компьютерные центры часто располагаются вне университета».

Унификация оборудования и отлаженное FOSS также облегчает многим центрам выход онлайн и возможность предложить свои ресурсы сети. В июне Сассекс стал центром T2. Университет присоединился к проекту ATLAS в 2009 году, когда д-р Сальваторе и д-р Антонелла Де Санто [Antonella De Santo] вошли в проект от Университета Роял Холлоуэй [Royal Holloway], еще одного центра T2, создав группу ATLAS. Благодаря их работе Сассекс получил финансирование, так что д-р Сальваторе, д-р Де Санто и кафедра ИТ смогли создать центр обработки данных на 12 стоек, со 100 CPU и 150 TБ хранимых данных, в зале с естественным охлаждением, затратив 80 000 фунтов.

[править] Углубимся в детали

Помимо управления пакетной обработкой данных для тысяч результатов, ежедневно поступающих в WLCG HEP, процесс научного исследования экспериментальных данных также требует подхода, основанного на открытом коде. Все участники эксперимента отвечают за постоянное улучшение программы в плане ее способности выделить значительные события среди миллиардов частиц.

Нет ничего невозможного в том, чтобы быть физиком и при этом не разбираться C++ и не знать, как оптимизировать код с помощью компилятора, но это входит в программу обучения в Сассексе и других учреждениях HEP.

«Наше сообщество было сообществом открытого кода задолго до того, как оно получило это название, – говорит Берд. – Мы используем коммерческое ПО там, где это нужно и можно, но все программы для анализа наших собственных данных написаны у нас же, потому что для выполнения такой работы больше ничего не существует».

Величина и сложность ATLAS и CMS означает наличие сотен профессионалов в области ПО, работающих над созданием и поддержкой кода, но, поскольку разные центры занимаются разными частями эксперимента, такие инструменты, как SVN, жизненно важны для управления работой над каждым алгоритмом. «Вы не смогли бы сделать этого в другой операционной системе, – говорит д-р Сальваторе. – С инструментами вроде SVN проще работать изнутри ОС, и мы это определенно эксплуатируем, как можно глубже проникая в ОС; в проприетарных же системах ОС скрыта за несколькими уровнями».

Однако управление результатами работы тысяч академиков HEP – это задача, требующая не просто управления версиями. «Здесь присутствует и некая доля социологии, – говорит Калафиура. – При наличии 3000 участников нужны особые процедуры, чтобы выяснить, кто является членом ATLAS, а кто подписывает документ о Хиггсе. Существует система кредитов. Традиционно это либо работа с детектором, либо разработка программ. Если у кого-то есть хороший алгоритм для отслеживания движения частицы по детектору, они тратят несколько лет на совершенствование этого алгоритма и передают его в общий программный репозиторий, и он становится частью официальных инструкций. До 2010 года большая часть вклада в развитие ПО была сделана физиками, и только в области ядра трудились профессионалы. А затем все изменил тот момент, когда начали поступать реальные данные. В течение нескольких последних лет физики используют инструменты, подготовленные куда меньшим сообществом. Я занимаюсь физикой высоких энергий большую часть своей жизни, и каждый раз, когда эксперимент начинает предоставлять данные, большая часть сообщества сразу теряет всякий интерес к техническому аспекту».

Зачастую исследования начинаются с того, что физики разрабатывают теоретическую базу для расчета результатов события, в котором появится бозон Хиггса. Как только ученый предлагает определенный сценарий, начинаются попытки смоделировать его, используя Monte Carlo, программу, работающую на основе сети распределенных вычислений, которая пытается спрогнозировать, что произойдет при столкновении протонов. Результаты сравниваются с базой данных реальных результатов, чтобы выяснить, кто будет проводить дальнейшие исследования. Событие, в котором выявляется вероятность появления частицы Хиггса, появляется из набора данных, состоящего примерно из квадриллиона столкновений. Есть группы ученых и разработчиков ПО, связанные с каждой частью «основных» компьютерных ресурсов, которые управляют поведением БАК и основным отбором данных.

[править] Будущее

Поскольку в конце года БАК будет отключен на модернизацию, естественно, что в высших эшелонах проекта вычислений шло немало дебатов по поводу того, чем будет заниматься WLCG, чтобы соответствовать возросшим требованиям экспериментов в области физики высоких энергий.

«Когда мы начали всю эту работу, – говорит Берд, – нас беспокоила сеть, получение достаточной скорости передачи и надежность всего этого. Все получилось просто фантастическим и превзошло все ожидания. Поэтому сегодня вопрос звучит так: “Как нам использовать сеть еще лучше?” Мы ищем более разумные способы использования сети, кэширования и передачи данных, когда того потребует работа, вместо попыток выяснить, где они потребуются».

Неизбежно возникает тема облачных вычислений. Нечто вроде EC2, например, непрактично для повседневного использования, из-за высокой стоимости передачи данных с и на серверы Amazon. Однако он может пригодиться для добавочных вычислений во время проведения основных конференций, поскольку на них всегда есть спрос, когда ученые работают над завершением своих статей и уточнением результатов. Большинство кластеров сети предназначены для 90 % использования своих ресурсов при обычных обстоятельствах, и в них недостаточно свободных циклов, которые можно было бы задействовать.

- Метамодернизм в позднем творчестве В.Г. Сорокина

- ЛитРПГ - последняя отрыжка постмодерна

- "Ричард III и семиотика"

- 3D-визуализация обложки Ridero создаем обложку книги при работе над самиздатом.

- Архитектура метамодерна - говоря о современном искусстве, невозможно не поговорить об архитектуре. В данной статье будет отмечено несколько интересных принципов, характерных для построек "новой волны", столь притягательных и скандальных.

- Литература

- Метамодерн

- Рокер-Прометей против изначального зла в «Песне про советскую милицию» Вени Дркина, Автор: Нина Ищенко, к.ф.н, член Союза Писателей ЛНР - перепубликация из журнала "Топос".

- Как избавиться от комаров? Лучшие типы ловушек.

- Что делать если роблокс вылетает на windows

- Что делать, если ребенок смотрит порно?

- Почему собака прыгает на людей при встрече?

- Какое масло лить в Задний дифференциал (мост) Visco diff 38434AA050

- О чем может рассказать хвост вашей кошки?

- Верветки

- Отчетность бюджетных учреждений при закупках по Закону № 223-ФЗ

- Срок исковой давности как правильно рассчитать

- Дмитрий Патрушев минсельхоз будет ли преемником Путина

- Кто такой Владислав Поздняков? Что такое "Мужское Государство" и почему его признали экстремистским в России?

- Как правильно выбрать машинное масло в Димитровграде?

- Как стать богатым и знаменитым в России?

- Почему фильм "Пипец" (Kick-Ass) стал популярен по всему миру?

- Как стать мудрецом?

- Как правильно установить FreeBSD

- Как стать таким как Путин?

- Где лучше жить - в Димитровграде или в Ульяновске?

- Почему город Димитровград так называется?

- Что такое метамодерн?

- ВАЖНО! Временное ограничение движения автотранспортных средств в Димитровграде

- Тарифы на электроэнергию для майнеров предложено повысить

«С использованием коммерческих облаков есть проблемы – оно обходится значительно дороже, чем мы можем сделать сами, – говорит Берд. – С другой стороны, имеются такие технологии, как OpenStack, которые крайне интересны. Сейчас мы используем пилотный кластер OpenStack, который позволяет нам предлагать разные виды сервисов и дает возможность применять другой способ соединения центров обработки данных – это не совсем то, что нам нужно, но мы стараемся идти в ногу с технологиями, чтобы не застаиваться, не вязнуть в болоте, занимаясь тем, чем больше никто не занимается».

Столь же горячей темой для обсуждения среди разработчиков ATLAS является GPGPU. «Некоторые академики, например, в Глазго, рассматривают возможность портирования своего кода в GPGPU, – говорит Гронбах из GridPP, – но вопрос в том, соответствует ли тип анализа, который они делают, данному типу обработки данных. Большая часть нашего кода является тем, что известно под названием “усложненного параллелизма”, мы можем нарезать события и данные на порции и отправить каждую из этих порций на отдельный CPU, и ему незачем знать, как решаются другие задачи. Но сама по себе эта задача не параллельная; она не очень хорошо вписывается в обработку данных типа GPU».

По словам Берда, большой интерес вызывает ожидаемое оборудование Intel Larabee/Xeon Phi.

И хотя по поводу развития самой крупной в мире сети распределенных вычислений ведутся оживленные дебаты, можно со всей определенностью сказать, что работа CERN будет продолжаться, и будет становиться все более требовательной каждый год. Существование бозона Хиггса пока не подтверждено, цель Большого адронного коллайдера пока не достигнута и не является единственной задачей, над которой он работает. Это всего лишь первый крупный анонс множества – будем надеяться – грядущих событий.

Поэтому в следующий раз, любуясь звездами и предаваясь философским размышлениям о том, как же все это началось, помните, что все наши недавно полученные знания о жизни, Вселенной и обо всем остальном – это результат труда тысяч ученых и некого замечательного пингвина. |